Wie Reporting-Plattformen nachhaltig wachsen können

Dieser Blogartikel ist Teil 2 dieses Artikels.

Dort analysieren wir, worin das Grundproblem wachsender Reporting-Strukturen liegt und kommen zu dem Schluss, dass die mit der Zeit ansteigende Komplexität der Hauptfaktor ist.

Zwei Maßnahmen damit umzugehen, haben wir bereits vorgestellt:

-

Die erste Maßnahme ist es, zentrale semantische Modelle bereitzustellen. So können die Ressourcen gebündelt werden. Die zentralen Datasets sind getestet und gepflegt und werden für mehrere Berichte und Analysen verwendet.

-

Die zweite Empfehlung ist die zentralen Datasets im Star Schema zu modellieren. Das bietet verschiedene Vorteile. Zum einen ist es einfach auszuwerten und zu verstehen. Wichtig für das spätere Anwachsen ist zudem: Star-Schemata lassen sich gut ergänzen, ohne die Gesamtkomplexität unnötig zu erhöhen.

Damit hat man eine gute Ausgangslage für zukünftiges Wachstum. Die folgenden Handlungsempfehlungen sollen sicherstellen, dass zukünftiges Wachstum nachhaltig bleibt.

Durch Standardisierung Erweiterungen erleichtern

Nachdem wir unsere Datenmodelle so modellieren, dass sie darauf ausgelegt sind, erweitert zu werden, wollen wir den Aufwand für Erweiterungen minimieren und gleichzeitig die Wartbarkeit erhöhen, indem wir die Erweiterung standardisieren und vereinfachen.

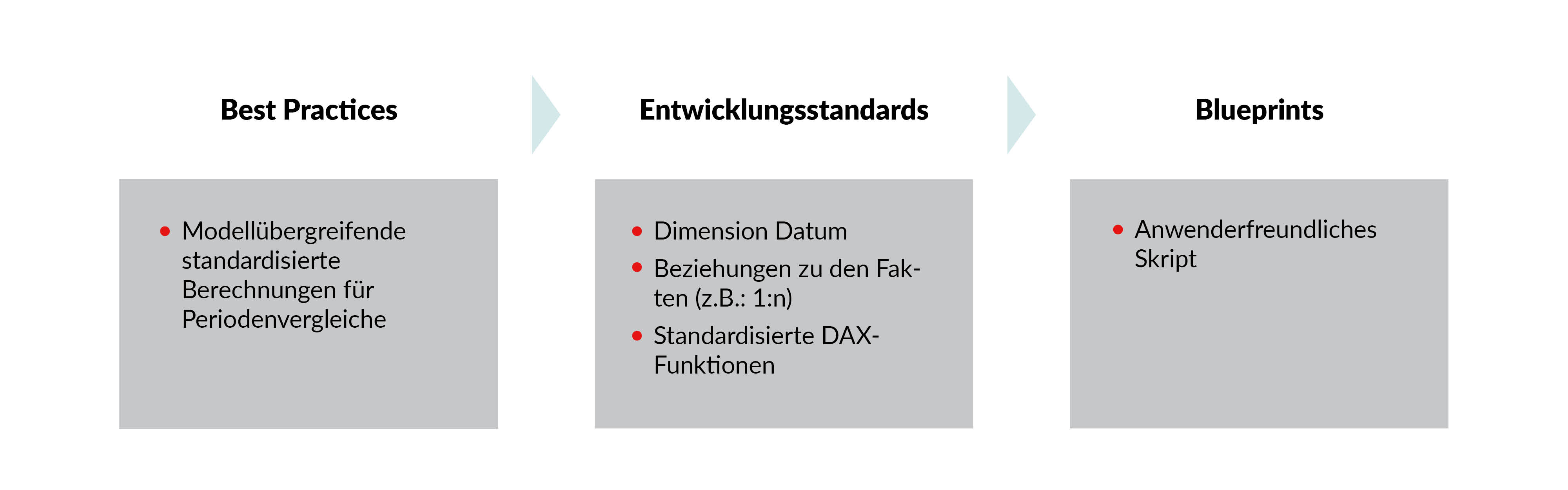

Um Wildwuchs zu vermeiden, sollten Unternehmen Best Practices für die Verwendung von Power BI definieren. Doch das reicht noch nicht für eine gelungene Umsetzung. Zusätzlich sollten diese Best Practices in konkrete Entwicklungsstandards übersetzt werden. Idealerweise existieren Blueprints, welche die Einhaltung der Regeln sicherstellen.

Um es greifbarer zu machen, hier ein konkretes Beispiel. Eine übliche Best-Pratice-Regel ist, dass es standardisierte Berechnungen für Periodenvergleiche (YTD etc.) geben soll. Die daraus abgeleiteten Entwicklungsstandards wären dann zum Beispiel, dass eine (bestimmte) Datumsdimension verwendet werden soll,wie die Beziehung zu den Fakten gesetzt werden soll und welche standardisierten Dax Funktionen für die Berechnung verwendet werden sollen. All diese Vorgaben machen den Entwicklern erstmal Arbeit, stellen aber die zukünftige Wartbarkeit sicher. Ein Blueprint in diesem Szenario wäre ein Skript, welches die Measure für die Periodenvergleiche automatisiert erstellt. Ein solches Skript finden Sie beispielsweise hier. Der Blueprint sorgt für Arbeitserleichterung und stellt sicher, dass die Standards auch unter Zeitdruck eingehalten werden.

Durch die Blueprints werden nicht nur die Best Practices eingehalten, sondern auch die Erweiterung für die Entwickler erleichtert. Entwickler müssen nur ein Skript ausführen und nicht viele manuelle Arbeitsschritte durchführen. Der verringerte Aufwand führt meist dazu das die Skripte auch von den Entwicklern eingesetzt werden. Hier geht es zur Videoerklärung.

Durch klare Ansprechpartner Probleme frühzeitig erkennen

Auch wenn Unternehmen die erste drei Punkte umsetzen, wird es immer zu Fragen, Unsicherheiten und Problemen bei den Nutzern kommen. Anwender, die auf eine Herausforderung treffen müssen, schnell und einfach zugänglich Unterstützung bekommen können. Andernfalls besteht die Gefahr das durch individuelle Lösungen, die stark von den Best Practices abweichen, die Probleme aus dem ersten Abschnitt wieder auftreten.

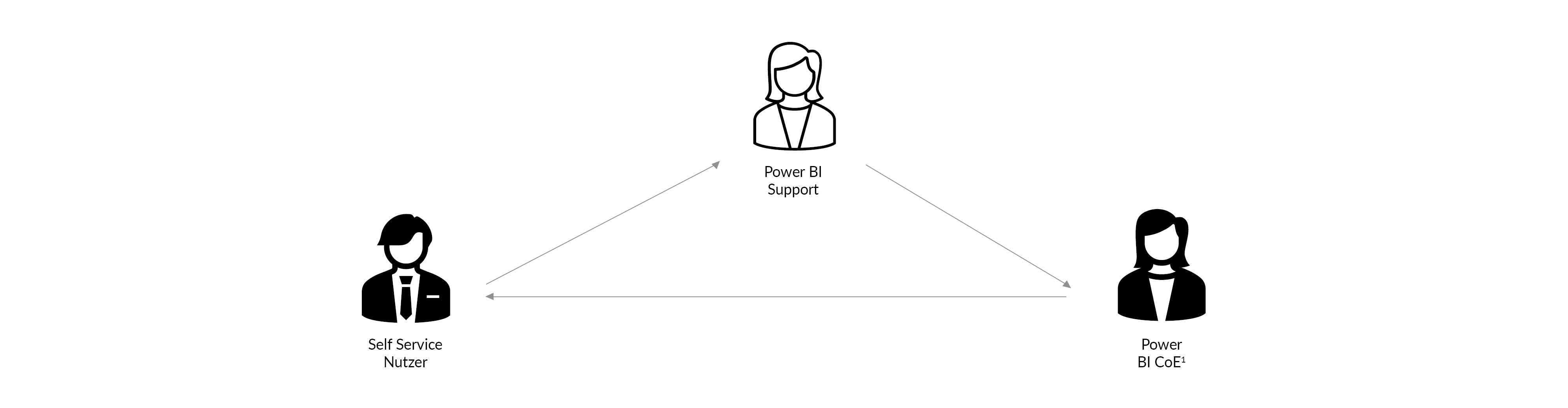

Generell empfehlen wir die Arbeitsaufteilung in drei Gruppen:

-

Die Power BI Self Service Nutzer. Das sind alle die Power BI nutzen um mit den Daten zu arbeiten. Für Schulungen und Rechtevergabe ist eine weitere Differenzierung zwischen reinen Berichtsempfänger, Berichtsersteller und Power Usern, welche selbst neue Daten anbinden können, sinnvoll.

-

Der Betrieb hat die Administratoren-Rechte und ist dafür da, die Umgebung am Laufen zu halten. Kapazitätsüberwachung, Gateway-Verwaltung und das Verwalten von Berechtigungen gehören zu den typischen Aufgaben.

-

Im Center of Exzellenz werden die Grundlegenden Konzepte zur Nutzung von Power BI entwickelt. Dazu gehören Zusammenarbeitsmodelle und Arbeitsbereichsstrukturen, Entwicklungsstandards etc. Außerdem ist das CoE der Ansprechpartner für den Betrieb und die Nutzer bei komplexeren Fragen. Je nach Organisationsmodell, kann es sinnvoll sein, dass das CoE in die Entwicklung zentraler geteilter Datasets miteinbezogen wird.

In vielen Fällen kann Unterstützung durch gutes Infomaterial und Dokumentation abgebildet werden.

In anderen Fällen ist weitere Unterstützung notwendig.

Eine Möglichkeit Fragen zu klären sind Community Kanäle. Das sind Tool-spezifische Kanäle, die für alle drei Nutzergruppen offen sind. Diese können genutzt werden, um auftretende Fragen zentral zu klären. Häufig können sich Nutzer auch gegenseitig helfen. Diese Kanäle können auch dafür genutzt werden, über Neuerungen oder aktuelle Probleme zentral zu informieren.

Bei spezielleren Problemen, die nur für wenige relevant sind, wenn es um Zugriffsrechte einzelner oder um sensible Daten geht, sind diese öffentlichen Kanäle nicht der richtige Ort. Mit diesen Problemen sollten sich die Nutzer an den Betrieb wenden. Ist auch der Betrieb überfragt, wird das CoE eingeschaltet.

Realität: Wo fangen wir an?

Wir haben Best-Practices festgelegt und Verantwortlichkeiten verteilt. Wie gehen wir jetzt beim Aufräumen mit unserer gewachsenen Umgebung vor? Wie hier vorzugehen ist, wird in den nächsten zwei Abschnitten erläutert.

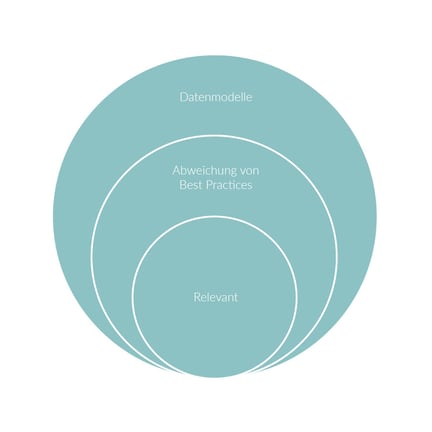

IST-Analyse

Der erste Schritt ist eine IST-Analyse. Wie sieht die Reportingstruktur aus? Welche Datasets gibt es? Welche dieser Modelle weichen von den Best-Practices ab? Diese Analyse kann durch Tools unterstützt werden. Zum Beispiel können über die PBI Rest API die Berichte und Datasets der Umgebung ausgelesen werden. Einzelne semantische Modelle können mit dem Best-Practice Analyzer auf Abweichungen von den Unternehmensvorgaben geprüft werden. Ein Set an Beispielregeln findet sich hier ergänzend dazu die Videoerklärung.

Im zweiten Schritt sollte analysiert werden, welche der abweichenden Modelle Probleme machen. Best-Practices sind kein Selbstzweck. Nur bei den Modellen, die Probleme verursachen lohnt es sich Arbeit in die Verbesserung zu stecken.

Zwei Handlungsoptionen

Nachdem die relevanten Modelle mit Handlungsbedarf identifiziert worden sind, ist eine zweite Einteilung notwendig. Hier geht es um eine Kosten-Nutzen-Abschätzung.

Bei der Behebung von Problemen gibt es häufig zwei Lösungsstrategien:

-

Das Pflaster: eine schnelle, einfache Lösung, die die Symptome mildert

-

Grundsanierung: das nachhaltige Beheben der Ursachen

Lösungen der ersten Kategorie können die schlimmsten Symptome mildern. Zum Beispiel können durch eine Schulung der Mitarbeiter und die enge Begleitung durch Power BI Experten, die berechneten Measuresoptimiert werden und so Performance-Probleme abmildern. Eine weitere solche Lösung kann die Auslagerung von komplexen Berechnungen in eigene Tabellen sein.

Die Alternative zum Pflaster ist die grundlegende Behebung der Ursachen. Das heißt, dass das ganze Datenmodell überarbeitet wird, das Datenmodell in der Datenbank erweitert wird oder sogar ganz neu aufgesetzt wird.

Da letzteres deutlich mehr Arbeit bedeutet, sollte gut abgewogen werden, wann es sinnvoll ist, diese zu investieren. Für zentrale Datenmodell mit vielen Anwendern lohnt sich oft die Grundsanierung. Kleinen Spezialauswertung reicht vielleicht ein Pflaster. In die Abwägung sollten auch potenzielleukünftige Änderungsanforderungen einfließen. Sind diese wahrscheinlich, ist eine Grundsanierung langfristig vielleicht die günstigere Alternative. Wird das Dataset nur für einen begrenzten Zeitraum benötigt, lohnt sich das eher nicht.

3 Learnings

Damit skalieren auf gewachsenen Strukturen möglich ist, ist ein klares Zielbild wichtig. Dieses Zielbild sollte zukünftige Änderungen bereits mitdenken. Damit die Umsetzung funktioniert, sollten diese Standards möglichst einfach zu befolgen sein. Hürden kann man hier durch Automatisierungslösungen senken.

Anwenderfreundlichkeit ist ein Schlüssel zum Erfolg. Nur wenn die Lösungen, das Skript und das Datenmodell schnell und einfach eingesetzt werden können, werden sie auch in der Breite verwendet. Das Einhalten von Best Practices sollte die einfachste Lösung für Anwender sein.

Für einen möglichst reibungsfreien Betrieb ist eine klare Rollenverteilung und niedrigschwellige Hilfsangebote für Nutzer wichtig. Das Aufräumen vorhandener Datenstrukturen, die nicht zum Zielbild passen, sollte nach Dringlichkeit und Aufwand priorisiert werden.

Haben Sie Fragen oder Anmerkungen? Gerne stehen Ihnen unsere Kolleg:innen Miklas Horstmann und Vera Elliger für einen Austauch zu Verfügung. Hier geht es zu unserem Kontaktformular.

Ähnliche Artikel

Mit der Power BI Dataset Automation Kosten und Ressourcen sparen

Power BI ist ein mächtiges Analysetool. Es hilft vielen Unternehmen wertvoller Erkenntnisse aus...Wie gelingt die Skalierung von Data Analytics

In einer datengetriebenen Welt stehen Unternehmen vor der Herausforderung, ihre Daten effektiv zu...Kontaktieren Sie uns, wir beraten Sie gern.

Informationsfabrik GmbH

Wo Entscheidungen immer schneller getroffen werden müssen - mit immer weitreichenderen Konsequenzen - liefern wir die Fakten.