Erklärbare KI: So werden Vorhersagen auf KI-Basis nachvollziehbar

KI-Technologien gewinnen immer mehr an Bedeutung. In Deutschland könnte der Umsatz aus Dienstleistungen und Produkten auf KI-Basis bereits in wenigen Jahren 13 Prozent des Bruttoinlandsprodukts ausmachen.

Doch auch wenn die Technologie bahnbrechende Perspektiven für Unternehmen verspricht, stehen viele Entscheider ihr mit Misstrauen gegenüber. Ein Grund dafür ist, dass in der Regel unklar ist, was genau ein Algorithmus mit den ihm vorgesetzten Daten macht und wie er zu bestimmten Ergebnissen gelangt. Daher spielt das Thema Transparenz beim Einsatz von KI in Organisationen aller Art eine zunehmend wichtige Rolle.

Trusted AI als Top-Priorität

Laut einer Studie von PwC stellt das Thema Trusted AI für 91 Prozent der Unternehmen, die KI-basierte Lösungen im Einsatz haben, eine Top-Priorität dar. Der Begriff steht für Strategien und Tools, die Anwendern dabei helfen sollen, den Datenverarbeitungsprozess von KI-Lösungen transparent zu machen.

White- und Black-Box-Modelle

KI-basierte Anwendungen funktionieren mithilfe sogenannter KI-Modelle. Dabei handelt es sich, einfach gesagt, um die algorithmischen Zusammenhänge, die bei der Datenanalyse für den jeweiligen Anwendungsfall zum Einsatz kommen. Im Hinblick auf ihre Transparenz unterscheidet man zwischen White- und Black-Box-Modellen. Bei White-Box-Modellen sind diese Zusammenhänge grundsätzlich nachvollziehbar. Bei Black-Box-Modellen (z. B. neuronale Netze) ist das aufgrund zu hoher Komplexität in der Regel nicht mehr möglich. Um hier die nötige Transparenz zu gewährleisten, kommen Erklärungswerkzeuge wie SHAP zum Einsatz.

In diesem Blogbeitrag zeigen wir am Beispiel eines Next-Best-Offer-KI-Modells, wie die Vorhersagen und Handlungsempfehlungen eines KI-Modells mithilfe des Erklärungswerkzeugs SHAP nachvollziehbar werden.

Was bedeutet Next Best Offer ?

Next Best Offer (NBO) ist ein Bestandteil dessen, was wir Next Best Action Marketing nennen. Wie der Name schon sagt geht es darum, mithilfe von Algorithmen die Handlungsoptionen mit den besten Erfolgsaussichten zu ermitteln. Im Falle von Next Best Offer geht es dabei um das beste Angebot, das man einem Kunden auf Basis der über ihn verfügbaren Daten machen kann.

Das NBO-Modell auf KI-Basis

Unsere Lösung ermittelt das NBO mithilfe eines Vorhersagemodells, in dem anhand relevanter Datenpunkte ermittelt wird, welches Angebot für einen Kunden mit welcher prozentualen Wahrscheinlichkeit am meisten Erfolg verspricht. Als Datengrundlage kommen dabei zum Beispiel die Kundenstammdaten und die Kaufhistorie zum Einsatz.

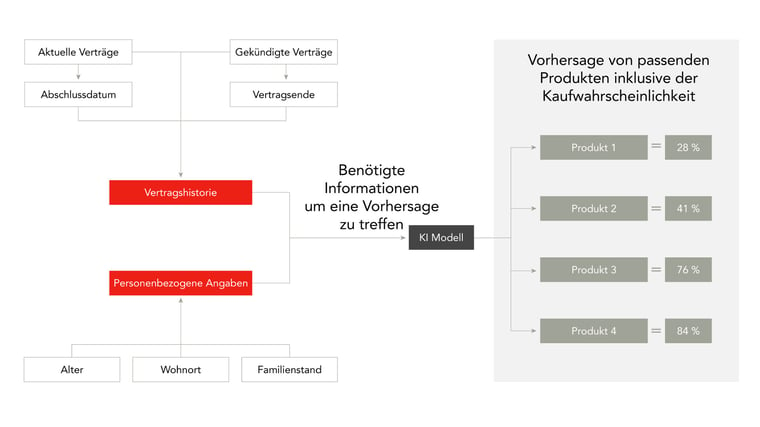

Die nachfolgende schematische Darstellung zeigt das zugrundeliegende Prinzip des KI-gestützten NBO-Modells:

Anhand eines konkreten Beispiels wird es noch deutlicher:

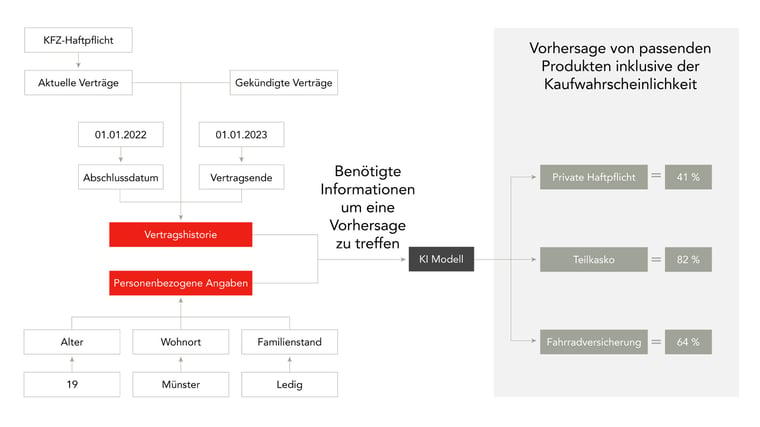

Max Mustermann ist 19 Jahre alt, ledig und wohnt in Münster. Für seinen ersten PKW hat er nach einer passenden KFZ-Haftpflicht Versicherung gesucht und ist durch die ausgezeichneten Konditionen der XY AG nun Neukunde geworden. Mithilfe dieser Informationen und dem skizzierten NBO-KI-Modell kann eine KI-Lösung weitere passende Angebote einschließlich einer Kaufwahrscheinlichkeit ermitteln.

Die allgemeine schematische Abbildung sieht für den konkreten Fall von Max Mustermann dann so aus:

Das KI-Modell hat ermittelt, dass für Max drei verschiedene Angebote in Frage kommen – einschließlich der jeweiligen prozentualen Kaufwahrscheinlichkeit. Auf dieser Basis könnte nun ein erfahrener Vermittler entscheiden, Max per E-Mail ein Angebot für eine Teilkaskoversicherung zu senden, da die Kaufwahrscheinlichkeit hier mit Abstand am höchsten ist. Die Teilkaskoversicherung ist hier also die NBO.

Jedoch besteht dabei das Problem der fehlenden Transparenz. Der Vermittler weiß nicht, wie und warum die KI zu dem Ergebnis gekommen ist und kann daher auch nicht beurteilen, ob es zutreffend ist. Es bleibt ihm also nichts übrig, als der KI blind zu vertrauen. Da allerdings niemand einem Algorithmus blind vertrauen will, wird es immer wichtiger, dass KI-Modelle mittels xAI erklärbar sind.

Erklärbarkeit hilft Entwicklern dabei, die Funktionsfähigkeit eines Modells zu evaluieren. Sie kann außerdem wichtig sein, um regulatorische Standards zu erfüllen. Vor allem jedoch gibt sie Entscheidungsträgern in Unternehmen die Möglichkeit, datenbasierte Handlungsempfehlungen kritisch zu hinterfragen und gegebenenfalls anders zu entscheiden.

Je nach Anwendungsfall eignen sich verschiedene Strategien und Werkzeuge, um KI-Prozesse erklärbar zu machen.Nachfolgend zeigen wir, wie KI-Modelle anhand sogenannter Shapley-Werte nachvollziehbar werden.

Erklärbare KI mittels SHAP

Eine von mehreren etablierten Vorgehensweisen, um Black-Box-Modelle erklärbar zu machen, nennt sich SHAP. Es basiert auf einem wissenschaftlichen Paper von Lundberg und Lee aus dem Jahr 2017. Der darin vorgestellte Algorithmus SHapley Additive exPlanations (SHAP) dient zur Interpretation von Modell-Vorhersagen und soll naturgemäß vor allem eine Frage beantworten: „Wie ist ein KI-Modell auf ein bestimmtes Ergebnis gekommen?“

Die Grundlage für den SHAP-Algorithmus bilden die sogenannten Shapley-Werte.

Shapley-Werte

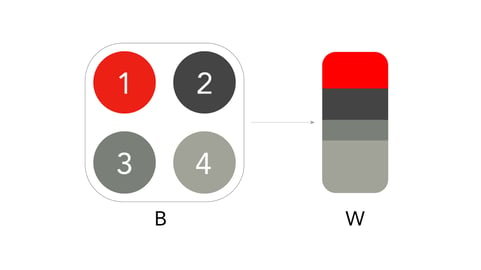

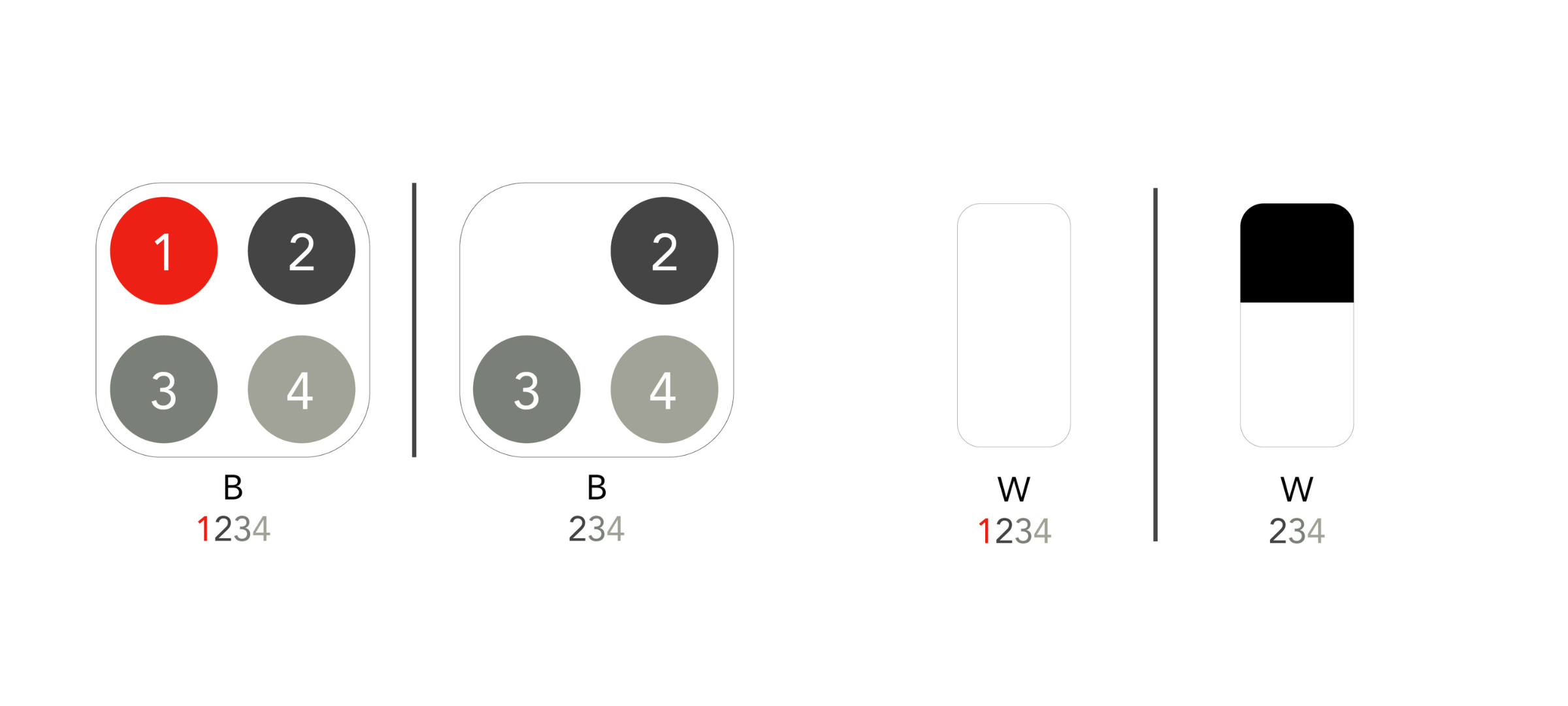

Angenommen, es existiert ein Bündnis B aus vier Mitgliedern, die gemeinsam daran arbeiten, einen Wert W zu produzieren. Die Shapley-Werte für jedes einzelne Mitglied des Bündnisses B beschreiben, wie viel jedes Mitglied zur Produktion des Wertes W beigetragen hat, wie nachfolgend skizziert:

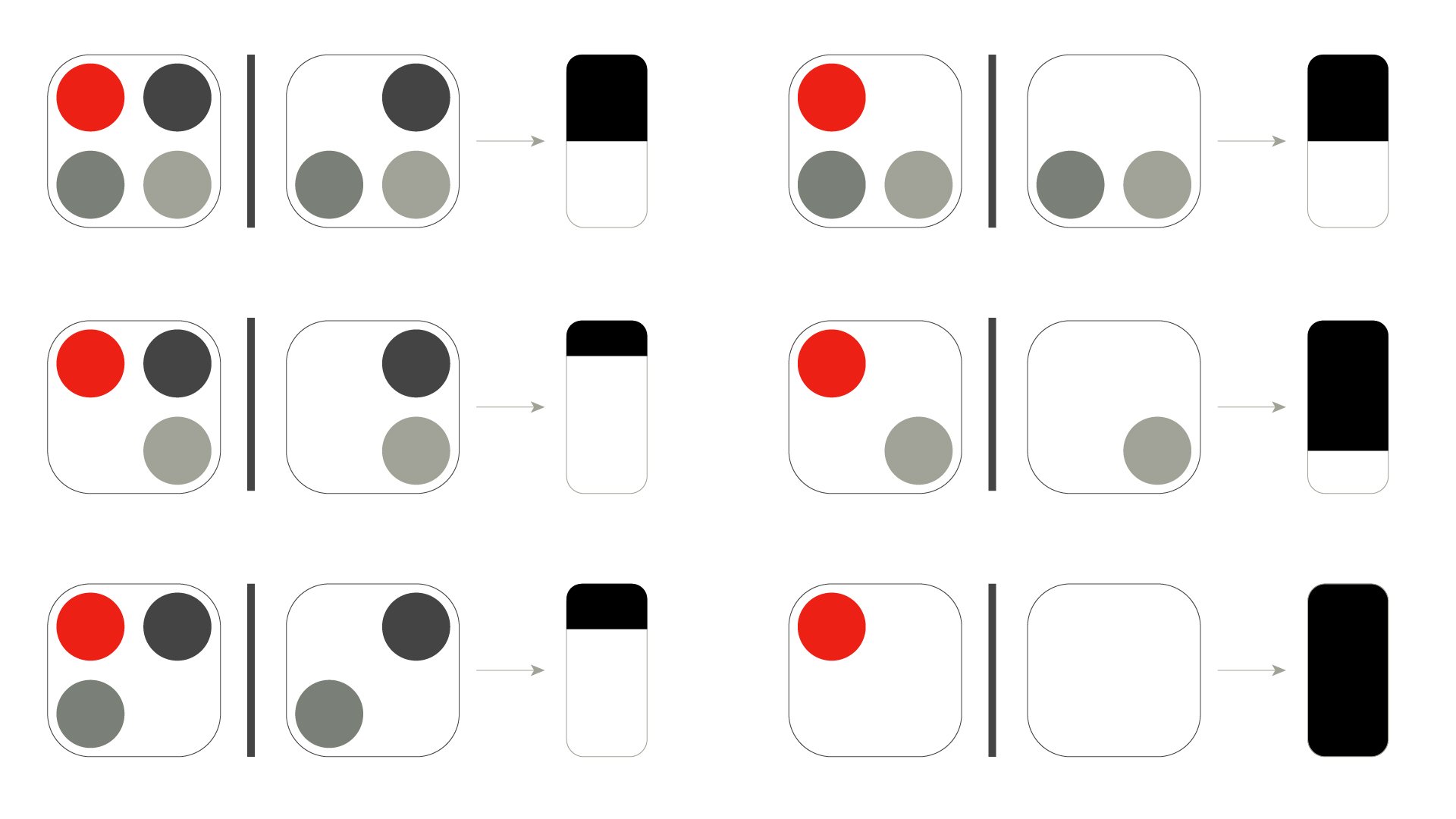

Die Berechnung der einzelnen Shapley-Werte ist komplex, da die einzelnen Mitglieder des Bündnisses B zur Schaffung des Wertes W miteinander interagieren und kollaborieren. Dabei ist es möglich, dass die Mitglieder unterschiedlich wertvoll für die Schaffung des Wertes W sind. Aus diesem Grund müssen alle möglichen Bündnis-Konstellationen gebildet werden, um den Einfluss der einzelnen Mitglieder gesondert betrachten zu können. Dies erfolgt auf Basis eines With/Without Ansatzes. Durch die Elimination eines einzelnen Mitglieds wird dessen Anteil am Gesamtergebnis kalkuliert.

Um beispielsweise den Einfluss für das erste Mitglied (rot) zu bestimmen, wird ein Bündnis B1234 gebildet, bei dem das erste Mitglied enthalten ist und ein weiteres Bündnis B234 ohne das erste Mitglied.

Beide Bündnisse B1234 und B234 produzieren nun jeweils einen Wert (W1234 und W234). Die Differenz der Werte W1234 zu W234 stellt dabei den marginalen Beitrag dar, den das erste Mitglied aus Bündnis B1234 zu Bündnis B234 hat (schwarze Box).

Beide Bündnisse B1234 und B234 produzieren nun jeweils einen Wert (W1234 und W234). Die Differenz der Werte W1234 zu W234 stellt dabei den marginalen Beitrag dar, den das erste Mitglied aus Bündnis B1234 zu Bündnis B234 hat (schwarze Box).

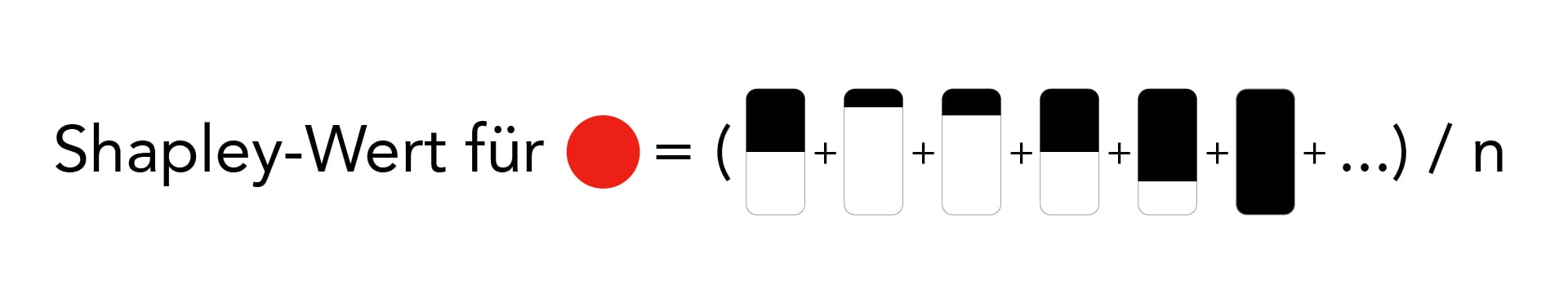

Um den allgemeinen Beitrag des ersten Mitglieds zur Erstellung eines Wertes W zu bestimmen, sprich den Shapley-Wert, werden nun alle möglichen Bündnis-Konstellationen bestimmt und der Mittelwert über die Differenzen der jeweiligen Werte gebildet.

Nachfolgend ist der Prozess zur Berechnung des Shapley-Wertes für das erste Mitglied (roter Kreis) grob skizziert (es sind nicht alle Bündnis-Konstellationen und Einflüsse visualisiert).

Im Anschluss an die Berechnung des Shapley-Wertes für das erste Mitglied wiederholt sich der Prozess für jedes einzelne der übrigen Mitglieder. Durch die Bestimmung der Shapley-Werte ist nun ersichtlich, wie viel Einfluss jedes Mitglied auf den Wert W hat. Die zuvor beschriebene Methodik zur Bestimmung der Shapley-Werte wird verwendet, um Modell-Vorhersagen erklärbar zu machen. Konkret stellt die Modell-Vorhersage den Wert W und die Features die Mitglieder des Bündnisses B dar. Die Shapley-Werte der einzelnen Features beschreiben somit, wie viel Einfluss das Feature auf die Modell-Vorhersage ausgeübt hat

SHAP-Analyse sorgt für Transparenz

Durch eine automatisierte SHAP-Analyse ist es möglich, Erkenntnisse über die Vorhersage eines KI-Modells zu gewinnen und so für Anwender nachvollziehbar zu machen, wie sie zustande gekommen ist.

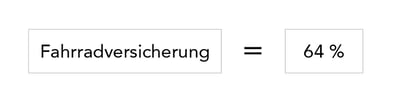

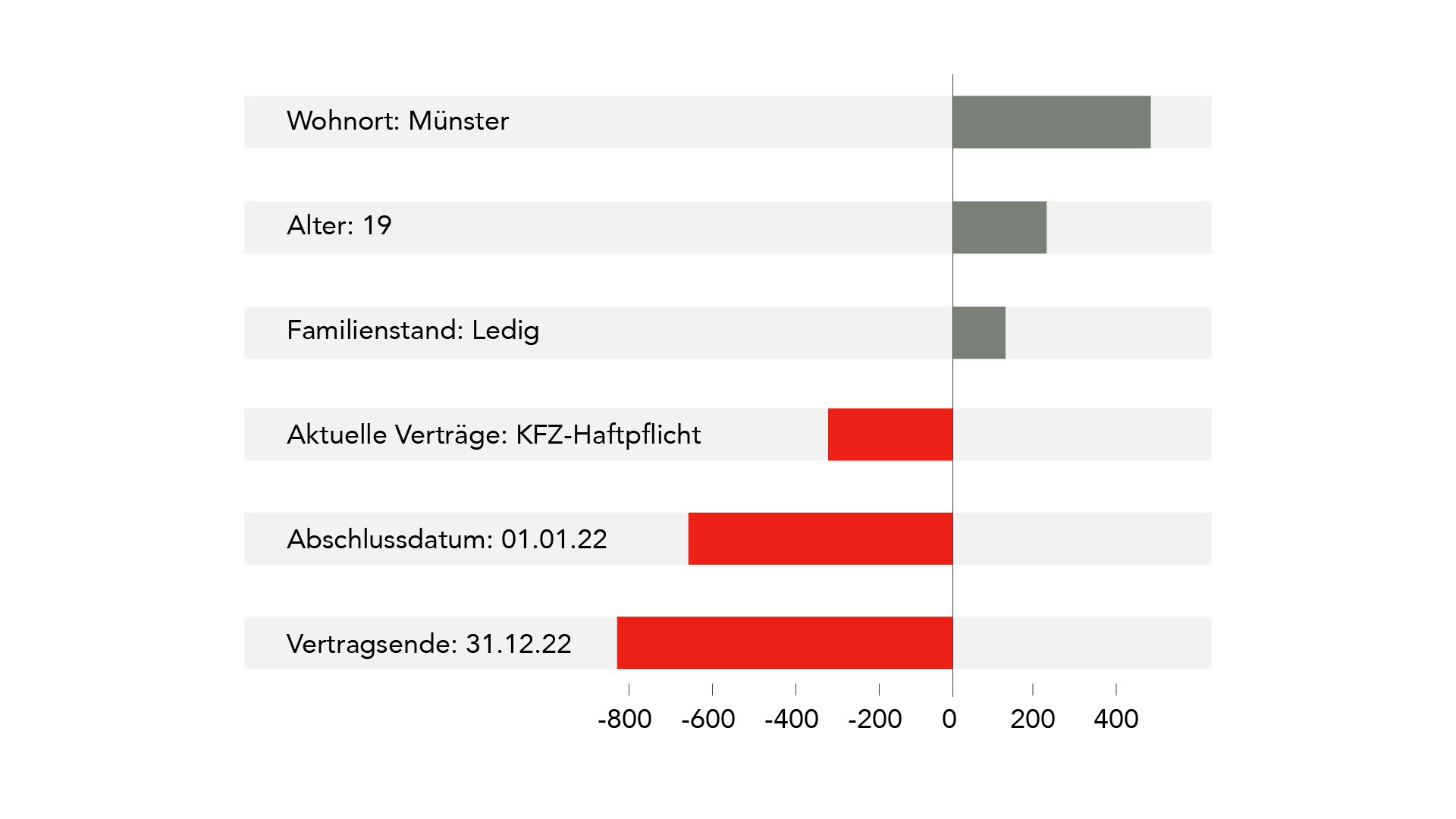

Konkret könnte eine SHAP-Analyse für unser Beispiel zu folgendem Ergebnis führen:

Vorhersage

Gewichtung der Features für die Fahrradversicherungsvorhersage (grafische Darstellung)

Erklärung

Für die Vorhersage über eine Fahrradversicherung mit einer Kaufwahrscheinlichkeit von 64 Prozent können wir mittels des SHAP-Algorithmus die Relevanz der einzelnen Features bestimmen (d. h. Wohnort, Alter, vorhandener KFZ-Haftpflicht Vertrag usw.)

Diese Darstellung ermöglicht es, die Features direkt ersichtlich als positiven bzw. negativen Einfluss auf die Wahrscheinlichkeit darzustellen. In unserem Beispiel haben der Wohnort und das Alter den größten positiven Einfluss auf die Wahrscheinlichkeit. Die vorhandene KFZ-Haftpflicht und insbesondere das erst kurz zurückliegende Abschlussdatum hingegen haben einen stark negativen Einfluss auf die Abschlusswahrscheinlichkeit einer Fahrradversicherung, was insgesamt zu einer Wahrscheinlichkeit unterhalb der durchschnittlichen Affinität für eine Fahrradversicherung führt.

Über die Analyse der für ein Einzelergebnis relevanten Features hinaus eignet die Methode sich auch, um globale Einflüsse der Features zu untersuchen. Dazu werden für ein Feature die Shapley-Werte für alle Ergebnisse betrachtet und zum Feature-Wert in Relation gesetzt.

So lassen sich ggf. Korrelationen zwischen dem Wert eines Features und dessen Einfluss auf das Ergebnis erkennen. Zum Beispiel könnte das Alter bei jungen Menschen tendenziell einen positiven Einfluss auf den Erwerb einer Fahrradversicherung haben, der mit zunehmendem Alter neutral wird und für sehr hohe Werte eher negativ ausschlägt.

Fazit

Wer KI-basierte Technologien nutzt, um beispielsweise Prozesse zu automatisieren oder das Kundenerlebnis datengestützt zu verbessern, möchte verständlicherweise wissen, wie genau ein Algorithmus zu bestimmten Handlungsempfehlungen gelangt. Erklärbare KI schafft Transparenz und macht Aussagen und Erkenntnisse aus KI-Modellen auch für Personen ohne tiefgehendes Fachwissen verständlicher . Das daraus resultierende Vertrauen ist eine grundlegende Voraussetzung für die groß angelegte Implementierung und den produktiven Einsatz von KI-Technologien in Unternehmen.

Sie möchten mehr über das Thema erfahren? Wir helfen Ihnen gerne weiter. Hier finden Sie unser Kontaktformular.

Ähnliche Artikel

Mit der Power BI Dataset Automation Kosten und Ressourcen sparen

Power BI ist ein mächtiges Analysetool. Es hilft vielen Unternehmen wertvoller Erkenntnisse aus...Die Evolution von Datenplattformen: Vom Data Warehouse zum Data Lakehouse

Die Geschichte der Datenplattformen reicht zurück bis in die 1960er und 1970er Jahre, als erste...Kontaktieren Sie uns, wir beraten Sie gern.

Informationsfabrik GmbH

Wo Entscheidungen immer schneller getroffen werden müssen - mit immer weitreichenderen Konsequenzen - liefern wir die Fakten.